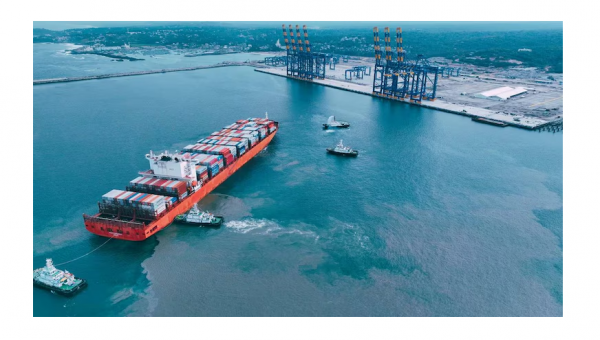

Những rủi ro tiềm ẩn của Trí tuệ nhân tạo

.jpg)

Chuỗi cung ứng phần mềm thường bị bỏ qua trong các cuộc thảo luận về rủi ro và bảo mật Trí tuệ nhân tạo (AI), kêu gọi quản trị hệ sinh thái bền vững và an toàn.

Vấn đề chuỗi cung ứng phần mềm của AI

Trí tuệ nhân tạo (AI), cả AI tạo sinh và AI phân biệt, có nhiều trường hợp sử dụng trong các lĩnh vực, phạm vi và khách hàng. Các nhà phát triển muốn xây dựng các giải pháp liên quan hiếm khi bắt đầu bằng cách phát triển một mô hình AI từ đầu; thay vào đó, họ dựa vào kho lưu trữ mô hình (hoặc còn gọi là Hồ mô hình – Model Lakes) để tận dụng các mô hình và thư viện được đào tạo trước như HuggingFace, PyPi và Kaggle. Điều này không nhất thiết chỉ có ở AI. Nói chung, các nhà phát triển tận dụng một lượng lớn mã của bên thứ ba khi xây dựng các sản phẩm độc quyền. Trong bối cảnh an ninh mạng, các thành phần của bên thứ ba này trở thành rủi ro tiềm ẩn đối với các nhóm sản phẩm.

Những kẻ tấn công nhận ra sự phức tạp của việc giải quyết rủi ro này và thường sử dụng các thành phần của bên thứ ba như một cách để xâm nhập vào các thực thể. Ví dụ, một ví dụ gần đây và nổi bật về một cuộc tấn công như vậy là do một tác nhân cố gắng khai thác một cửa hậu trong tiện ích XZ Utils được nhiều bản phân phối Linux sử dụng. Thư viện AI cũng có thể bị xâm phạm, ví dụ, bằng cách sử dụng tuần tự hóa không an toàn. Vấn đề này có thể trở nên trầm trọng hơn đối với các thư viện AI dựa trên các công nghệ không minh bạch hơn; ví dụ, kẻ tấn công có thể nhúng phần mềm độc hại vào trọng số mô hình.

Kẻ tấn công nhận ra sự phức tạp của việc giải quyết rủi ro này và thường sử dụng các thành phần của bên thứ ba như một cách để xâm nhập vào các thực thể.

Đáng chú ý hơn, rủi ro đối với các mô hình nguồn mở có thể bị thúc đẩy bởi các sự kiện địa chính trị rộng lớn hơn. Một ví dụ về điều này là Protestware, nơi những người bảo trì hoặc người đóng góp cho các dự án nguồn mở có thể cố tình xâm phạm mã cơ bản trong các phụ thuộc thượng nguồn chính để gây bất lợi cho các thực thể cụ thể. Điều này xâm phạm các ứng dụng chính và có thể dẫn đến các mối quan ngại về an ninh quốc gia.

Hạn chế của bảo mật thông qua tính minh bạch

Do đó, việc lựa chọn đúng các mô hình AI và các thư viện liên quan trở nên quan trọng không chỉ đối với chức năng của ứng dụng mà còn đối với các liên minh địa chính trị lớn hơn như QUAD, một nhóm gồm Úc, Ấn Độ, Nhật Bản và Mỹ, và các mối quan ngại về an ninh quốc gia của họ. Những lựa chọn này, do các thực thể riêng lẻ đưa ra trong vòng đời phát triển AI, phải được minh bạch đối với người tiêu dùng hạ nguồn. Nhiều nhà nghiên cứu đã đưa ra những đề xuất riêng biệt để giải quyết vấn đề minh bạch trong hệ sinh thái phát triển AI, bao gồm nhưng không giới hạn ở Danh mục vật liệu AI (AI BOM) và Thẻ mẫu.

Đề xuất của Manifest về AI BOM bao gồm siêu dữ liệu liên quan đến mô hình, kiến trúc của mô hình và cách sử dụng dự kiến hoặc dự định của mô hình. Linux Foundation đã đề xuất một phần mở rộng AI BOM cho định dạng System Package Data Exchange (SPDX) nổi tiếng được sử dụng theo chuẩn cho Software Bill of Materials (S BOM) tổng quát hơn. Phần mở rộng này tách hồ sơ AI khỏi tập dữ liệu mà AI được đào tạo. Tiêu chuẩn của Linux Foundation bổ sung cho đề xuất từ Manifest bằng cách cung cấp thêm thông tin về hiệu suất của mô hình, các cân nhắc về mặt đạo đức, tác động đến khí hậu, v.v.

AI BOM là phần mở rộng của Model Cards—lần đầu tiên được các nhà nghiên cứu tại HuggingFace đề xuất. Mục đích đằng sau Model Cards là tạo ra sự minh bạch trong mục đích sử dụng dự kiến của các mô hình đã đào tạo, cùng với hiệu suất của chúng trong bối cảnh của các nhóm đối tượng mục tiêu tiềm năng. Sự hiện diện của Model Cards tương quan với cách sử dụng trên HuggingFace, mặc dù các nhà nghiên cứu lưu ý rằng các phần về tác động môi trường, các hạn chế và đánh giá thường không đầy đủ.

Do đó, chỉ cung cấp Model Cards trên Model Lakes có thể không đủ để thúc đẩy việc áp dụng các mô hình này dựa trên rủi ro trong các sản phẩm AI. Đáng chú ý hơn, ở dạng hiện tại, chúng sẽ phải vật lộn để giải quyết các mối đe dọa địa chính trị khác nhau do Protestware gây ra cho các tổ chức như QUAD. Ví dụ, các tiêu chuẩn Model Card hiện tại, chẳng hạn như các tiêu chuẩn từ Linux Foundation, không cung cấp thông tin về các khía cạnh bảo mật chính như tính mạnh mẽ của đối thủ và không có sự thao túng có chủ đích.

Hệ sinh thái Model Lake bền vững và an toàn

Một giải pháp dành cho các quốc gia cũng như các tổ chức như QUAD là tạo ra Model Lake công-tư. Ở cấp độ chi tiết, chúng có thể được tạo ra để nhắm mục tiêu vào các trường hợp sử dụng cụ thể, các lĩnh vực riêng biệt hoặc các loại mô hình riêng lẻ. Các Model Lake riêng biệt có thể được kết hợp để tạo ra một Hệ sinh thái Model Lake (MoLE) bao quát bao gồm nhiều trường hợp sử dụng, lĩnh vực và loại mô hình. Sau đó, việc quản lý các hệ sinh thái như vậy có thể được chia thành nhiều tầng, trong đó một số khía cạnh nhất định được giải quyết ở cấp độ hệ sinh thái và những khía cạnh khác được quản lý ở cấp độ từng hồ riêng lẻ.

Những người tham gia vào các hệ sinh thái mô hình này có thể được chia thành Nhà sản xuất tài nguyên (RP), tức là các thực thể thêm các mô hình mới hoặc cập nhật các mô hình hiện có và Người dùng tài nguyên (RU), tức là các thực thể sử dụng các mô hình trong các sản phẩm AI hạ nguồn, trong đó đơn vị tài nguyên sẽ được định nghĩa là một mô hình. Nhà sản xuất tài nguyên có động cơ cố hữu để đảm bảo rằng hệ sinh thái được quản lý phù hợp để họ có thể thúc đẩy việc sử dụng các mô hình của mình. Người dùng tài nguyên cũng được khuyến khích tương tự để họ có thể yên tâm sử dụng các mô hình chất lượng cao trong các sản phẩm của mình, chẳng hạn như sẽ không trở thành nạn nhân của các cuộc tấn công Protestware tiếp theo. Với sự liên kết của các động cơ này, những người tham gia này có thể tự điều chỉnh để tạo ra các tiêu chuẩn Thẻ mô hình mới giải quyết các nhu cầu bảo mật của họ và đồng thời đảm bảo rằng các Thẻ mô hình tiếp theo được điền đầy đủ và chính xác.

Một khuôn khổ như vậy tạo điều kiện cho loại hình tự quản này, trong lĩnh vực tài nguyên thiên nhiên như nghề cá, rừng và hồ, là khuôn khổ Tài nguyên chung (CPR) đoạt giải Nobel của Elinor Ostrom. Bà xác định năm tiêu chí để tự quản thành công các nguồn tài nguyên này:

1. Chi phí giám sát tài nguyên phải thấp.

2. Tốc độ thay đổi trong hệ sinh thái của tài nguyên phải ở mức vừa phải.

3. Các bên liên quan liên quan phải thường xuyên giao tiếp và có kết nối xã hội chặt chẽ để thúc đẩy lòng tin thông qua vốn xã hội.

4. Có thể loại trừ những bên không phải là bên liên quan.

5. Sự hỗ trợ của các bên liên quan cho cả việc giám sát và thực thi các quy tắc liên quan.

Trong bối cảnh của Hồ mẫu, Thẻ mẫu cung cấp một cách để thiết lập vốn xã hội cho các mô hình (và theo nghĩa mở rộng là những người đóng góp cho mô hình) cho người dùng mô hình. Việc giám sát đòi hỏi phải đảm bảo rằng thông tin trên Thẻ mẫu là 1) có liên quan, 2) chính xác và 3) đầy đủ. Các bên liên quan có thể hỗ trợ điều này bằng cách báo cáo các Thẻ mẫu không đáp ứng các đặc điểm này. Những bên không phải là bên liên quan có thể được định nghĩa là những thực thể không cung cấp Thẻ mẫu hoặc cung cấp Thẻ mẫu chất lượng thấp. Họ có thể bị loại trừ bằng cách xóa thẻ của họ, loại bỏ mô hình của họ hoặc thu hồi quyền truy cập vào chính Hồ mẫu. Tốc độ thay đổi có thể được giữ ở mức vừa phải bằng cách đảm bảo giới hạn trên về số lượng mô hình mới được thêm vào và các mô hình cũ bị xóa, cũng như cung cấp dòng dõi giữa các mô hình và nhóm các mô hình liên quan lại với nhau.

Việc tạo ra các Hệ sinh thái Hồ mẫu như vậy, cho phép tự quản lý thông qua khuôn khổ CPR của Ostrom, mang lại một số lợi ích về mặt quản lý rủi ro trong Chuỗi cung ứng AI:

1. Các bên liên quan có thể xác định và giải quyết phạm vi rủi ro liên quan đến họ. Do đó, nếu Protestware là mối quan tâm có liên quan, thì các bên liên quan sẽ giải quyết nó.

2. Quản trị sẽ phát triển theo bản chất của các mối đe dọa. Điều này rất quan trọng trong AI vì cả bản chất của AI và các mối đe dọa liên quan đều đang phát triển nhanh chóng.

3. Nó cho phép các bên liên quan có ít nguồn lực hơn có thể tham gia bình đẳng vào việc quản lý hệ sinh thái.

4. Các chuẩn mực hoặc quy tắc liên quan sẽ ít có khả năng áp đặt các nghĩa vụ thẩm mỹ, vì các quy tắc sẽ được đưa ra bởi các thực thể sẽ chịu chi phí tuân thủ.

5. Quản trị dựa trên các động cơ hiện có vốn có của những người tham gia tài nguyên sẽ về cơ bản không mang tính cưỡng chế và do đó sẽ dẫn đến ít trường hợp không tuân thủ hơn.

Kết luận

Mặc dù AI có nhiều cơ hội và lợi ích, nhưng rủi ro tiềm ẩn thường bị che khuất bởi bản chất phức tạp của Chuỗi cung ứng AI. Việc giải quyết những rủi ro này là tối quan trọng, đặc biệt là khi chúng ảnh hưởng đến lợi ích an ninh quốc gia. Đối với Hoa Kỳ và Ấn Độ, những lợi ích này có thể bao gồm đảm bảo rằng các hệ sinh thái AI thống trị thấm nhuần các giá trị dân chủ và hỗ trợ nhân quyền. Chúng chắc chắn sẽ bao gồm đảm bảo rằng việc phụ thuộc vào các sản phẩm AI không tạo ra các rủi ro vô hình có hệ thống trên toàn bộ cơ sở hạ tầng quan trọng.

Quan hệ đối tác Mỹ-Ấn Độ nhằm tạo ra Hệ sinh thái hồ mô hình cho các trường hợp sử dụng an ninh quốc gia quan trọng trong AI có thể làm sáng tỏ những rủi ro ít thấy hơn và cho phép các bên liên quan có quyền lợi được giải quyết ngay từ đầu. Theo Ostrom, chúng ta phải nhìn xa hơn thị trường và các quốc gia để hướng đến những người nắm giữ cả kiến thức và năng lực quản trị bền vững.

Tác giả: Vaibhav Garg, Giám đốc điều hành nghiên cứu an ninh mạng và chính sách công của Comcast Cable.

- Share

- Copy

- Comment( 0 )

Cùng chuyên mục